@@ -344,6 +344,16 @@

- 【Git】在README.md中展示视频的方案

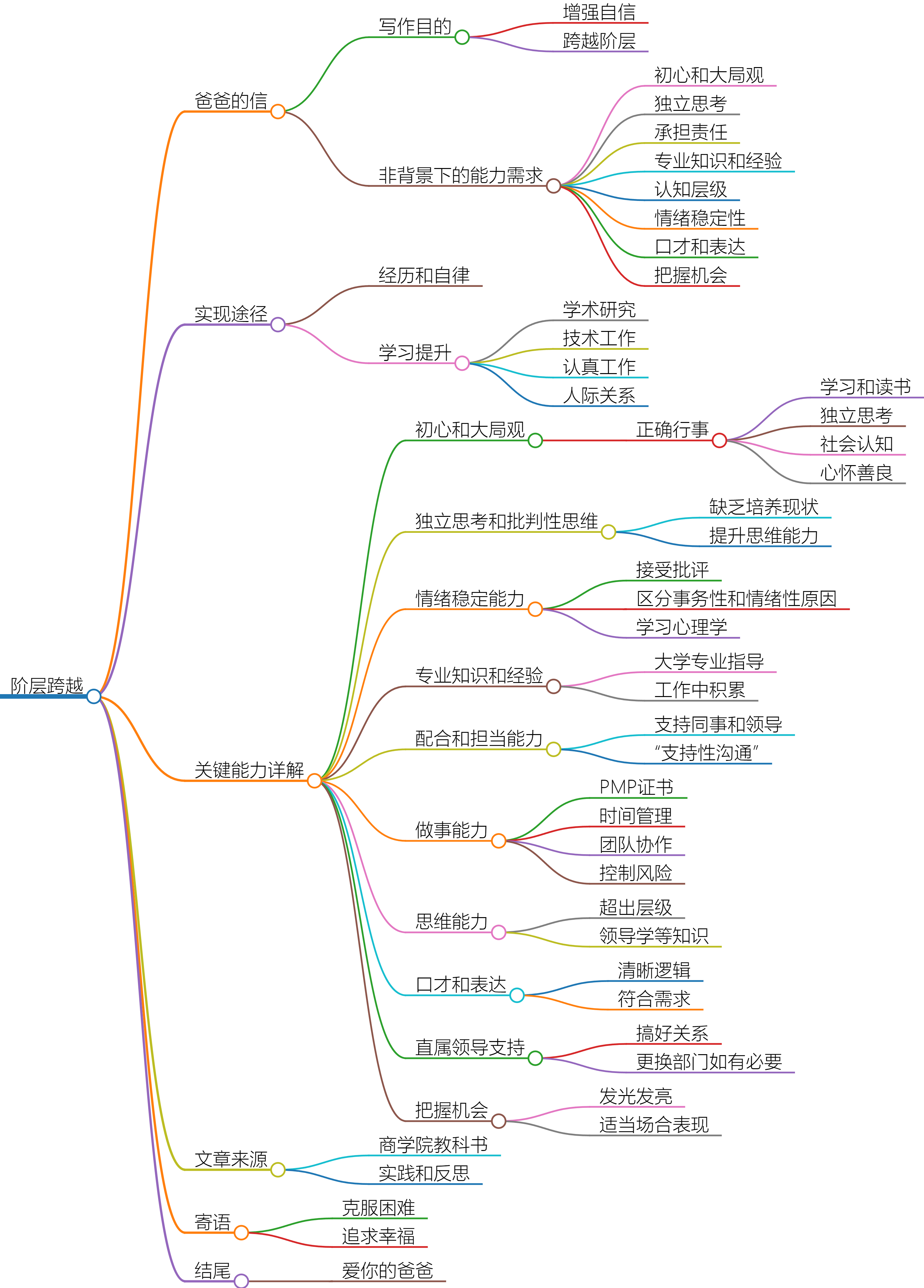

+ 【随笔】关于个人成长的思考

-

+

最新文章

@@ -263,13 +263,13 @@ 最新文章

@@ -278,13 +278,13 @@ 最新文章

@@ -293,13 +293,13 @@ 最新文章

diff --git a/categories/LLM/index.html b/categories/LLM/index.html

index 84c3d45..b64268f 100644

--- a/categories/LLM/index.html

+++ b/categories/LLM/index.html

@@ -217,7 +217,7 @@ 标签云

@@ -236,10 +236,10 @@ 最新文章

- 【Git】在README.md中展示视频的方案

+ 【随笔】关于个人成长的思考

-

+

@@ -248,13 +248,13 @@ 最新文章

@@ -263,13 +263,13 @@ 最新文章

@@ -278,13 +278,13 @@ 最新文章

@@ -293,13 +293,13 @@ 最新文章

diff --git a/categories/Unity/index.html b/categories/Unity/index.html

index d3af271..e895f37 100644

--- a/categories/Unity/index.html

+++ b/categories/Unity/index.html

@@ -217,7 +217,7 @@ 标签云

@@ -236,10 +236,10 @@ 最新文章

- 【Git】在README.md中展示视频的方案

+ 【随笔】关于个人成长的思考

-

+

@@ -248,13 +248,13 @@ 最新文章

@@ -263,13 +263,13 @@ 最新文章

@@ -278,13 +278,13 @@ 最新文章

@@ -293,13 +293,13 @@ 最新文章

diff --git a/categories/index.html b/categories/index.html

index 0fd73a6..144a5cd 100644

--- a/categories/index.html

+++ b/categories/index.html

@@ -219,7 +219,7 @@ 标签云

@@ -238,10 +238,10 @@ 最新文章

- 【Git】在README.md中展示视频的方案

+ 【随笔】关于个人成长的思考

-

+

@@ -250,13 +250,13 @@ 最新文章

@@ -265,13 +265,13 @@ 最新文章

@@ -280,13 +280,13 @@ 最新文章

@@ -295,13 +295,13 @@ 最新文章

diff --git a/categories/whatever/index.html b/categories/whatever/index.html

index f4836cb..68b7d4b 100644

--- a/categories/whatever/index.html

+++ b/categories/whatever/index.html

@@ -217,7 +217,7 @@ 标签云

@@ -236,10 +236,10 @@ 最新文章

- 【Git】在README.md中展示视频的方案

+ 【随笔】关于个人成长的思考

-

+

@@ -248,13 +248,13 @@ 最新文章

@@ -263,13 +263,13 @@ 最新文章

@@ -278,13 +278,13 @@ 最新文章

@@ -293,13 +293,13 @@ 最新文章

diff --git "a/categories/\346\225\260\346\215\256\347\273\223\346\236\204\345\222\214\347\256\227\346\263\225/index.html" "b/categories/\346\225\260\346\215\256\347\273\223\346\236\204\345\222\214\347\256\227\346\263\225/index.html"

index 778fc41..6072ec7 100644

--- "a/categories/\346\225\260\346\215\256\347\273\223\346\236\204\345\222\214\347\256\227\346\263\225/index.html"

+++ "b/categories/\346\225\260\346\215\256\347\273\223\346\236\204\345\222\214\347\256\227\346\263\225/index.html"

@@ -217,7 +217,7 @@ 标签云

@@ -236,10 +236,10 @@ 最新文章

- 【Git】在README.md中展示视频的方案

+ 【随笔】关于个人成长的思考

-

+

@@ -248,13 +248,13 @@ 最新文章

@@ -263,13 +263,13 @@ 最新文章

@@ -278,13 +278,13 @@ 最新文章

@@ -293,13 +293,13 @@ 最新文章

diff --git "a/categories/\346\235\202\351\241\271/index.html" "b/categories/\346\235\202\351\241\271/index.html"

index 9d74716..dfce67d 100644

--- "a/categories/\346\235\202\351\241\271/index.html"

+++ "b/categories/\346\235\202\351\241\271/index.html"

@@ -217,7 +217,7 @@ 标签云

@@ -236,10 +236,10 @@ 最新文章

- 【Git】在README.md中展示视频的方案

+ 【随笔】关于个人成长的思考

-

+

@@ -248,13 +248,13 @@ 最新文章

@@ -263,13 +263,13 @@ 最新文章

@@ -278,13 +278,13 @@ 最新文章

@@ -293,13 +293,13 @@ 最新文章

diff --git "a/categories/\350\257\273\344\271\246\347\254\224\350\256\260/index.html" "b/categories/\350\257\273\344\271\246\347\254\224\350\256\260/index.html"

index e00a828..43096b2 100644

--- "a/categories/\350\257\273\344\271\246\347\254\224\350\256\260/index.html"

+++ "b/categories/\350\257\273\344\271\246\347\254\224\350\256\260/index.html"

@@ -217,7 +217,7 @@ 标签云

@@ -236,10 +236,10 @@ 最新文章

- 【Git】在README.md中展示视频的方案

+ 【随笔】关于个人成长的思考

-

+

@@ -248,13 +248,13 @@ 最新文章

@@ -263,13 +263,13 @@ 最新文章

@@ -278,13 +278,13 @@ 最新文章

@@ -293,13 +293,13 @@ 最新文章

diff --git a/content.json b/content.json

index 7acba48..2c62489 100644

--- a/content.json

+++ b/content.json

@@ -1 +1 @@