diff --git a/.gitignore b/.gitignore

new file mode 100644

index 0000000..92d902f

--- /dev/null

+++ b/.gitignore

@@ -0,0 +1,2 @@

+/.quarto/

+_site/

\ No newline at end of file

diff --git a/_quarto.yml b/_quarto.yml

new file mode 100644

index 0000000..47c217c

--- /dev/null

+++ b/_quarto.yml

@@ -0,0 +1,91 @@

+project:

+ type: website

+

+website:

+ title: "Données émergentes"

+ navbar:

+ left:

+ - text: "Home"

+ file: index.qmd

+ - text: "Introduction"

+ file: introduction.qmd

+ - text: "Données administratives"

+ menu:

+ - administratives.qmd

+ - administratives_exemples.qmd

+ - text: "Données géolocalisées"

+ file: geolocalized_data.qmd

+ - text: "Analyse textuelle"

+ menu:

+ - textes.qmd

+ - textes_exemples.qmd

+ - text: "Analyse d'images"

+ menu:

+ - images.qmd

+ - images_exemples.qmd

+ - text: "Nowcasting"

+ menu:

+ - series_temporelles.qmd

+ - nowcasting_exemples.qmd

+ sidebar:

+ style: "docked"

+ search: true

+ contents:

+ - section: "Introduction"

+ contents:

+ - introduction.qmd

+ - section: "Données administratives"

+ contents:

+ - administratives.qmd

+ - administratives_exemples.qmd

+ - section: "Données géolocalisées"

+ contents:

+ - geolocalized_data.qmd

+ - section: "Analyse textuelle"

+ contents:

+ - textes.qmd

+ - textes_exemples.qmd

+ - section: "Analyse d'images"

+ contents:

+ - images.qmd

+ - images_exemples.qmd

+ - section: "Nowcasting"

+ contents:

+ - series_temporelles.qmd

+ - nowcasting_exemples.qmd

+ tools:

+ - icon: twitter

+ href: https://twitter.com

+ - icon: github

+ menu:

+ - text: Source Code

+ url: https://github.com/linogaliana/ensai-donnees-emergentes

+ - text: Report a Bug

+ url: https://github.com/linogaliana/ensai-donnees-emergentes/issues

+ page-navigation: true

+ page-footer:

+ left: "(c) 2022, Lino Galiana and Tom Seimandi"

+ right:

+ - icon: github

+ href: https://github.com/linogaliana/ensai-donnees-emergentes

+ - icon: twitter

+ href: https://twitter.com/

+ reader-mode: true

+ repo-url: https://github.com/linogaliana/ensai-donnees-emergentes

+ repo-actions: [edit, issue]

+ twitter-card:

+ creator: "@linogaliana"

+ open-graph: true

+

+

+bibliography: references.bib

+

+format:

+ html:

+ theme: cosmo

+ css: styles.css

+ toc: true

+

+theme:

+ light: flatly

+ dark: darkly

diff --git a/administratives.qmd b/administratives.qmd

new file mode 100644

index 0000000..1e8a81b

--- /dev/null

+++ b/administratives.qmd

@@ -0,0 +1,487 @@

+---

+title: "Données administratives"

+---

+

+La

+baisse généralisée au niveau

+européen des taux de réponse[^1] [@LuitenHoxde; @beck2022],

+qui accroît les coûts de collecte et

+rend plus difficile celle-ci sur certaines

+sous-populations, notamment les plus jeunes,

+nécessite de trouver des solutions pour

+répondre à la demande toujours accrue de

+statistique officielle.

+

+[^1]: Par exemple, le taux de réponse a baissé pour l'enquête en face-à-face Cadre de vie et sécurité de 72 % à 66 % entre

+2012 et 2021. En ce qui concerne SRCV (Statistiques sur les ressources et les conditions de vie), le taux

+de réponse est passé de 85 % à 80 % entre 2010 et 2019. Des événements

+ponctuels comme la crise du Covid-19 peuvent de plus avoir des

+effets très forts sur le taux de réponse.

+Par exemple, en 2020, à la date du 23 avril, le taux de réponse à l'enquête sur la production industrielle en mars, qui sert d'indicateur avancé de l'activité économique,

+était inférieur d'environ 20 points de pourcentage à ce qui est observé lors d’un mois habituel (voir [blog de l'Insee](https://blog.insee.fr/suivre-la-conjoncture-lorsque-les-entreprises-repondent-moins-aux-enquetes/)).

+

+

+Comme développé dans l'introduction, les données

+administratives sont des données de gestion

+produites par l'administration.

+Le processus de production statistique, où la collecte

+de donnée est construite de manière à mesurer

+le plus objectivement possible un phénomène cible,

+diffère du processus de production administratif.

+Pour cette dernière, la donnée est produite de sorte

+à faciliter la gestion. L'exploitation de celle-ci

+à des fins de production de statistique ou de recherche

+n'est pas le moteur de leur construction. L'exploitation

+de cette donnée est une affaire d'opportunité.

+Cette perte de contrôle du processus de production, qui

+fait que l'exploitant de la donnée se retrouve en aval

+de son processus de production, a tout de même des bénéfices :

+l'exhaustivité sur une population cible et

+la plus haute fréquence de ces données.

+Ceci explique qu'elles deviennent de plus en plus importantes

+dans la production de statistique officielle.

+

+Ce chapitre revient sur le contexte d'utilisation des données

+administratives, leurs différences avec d'autres sources

+de données et les apports de celles-ci à la production

+de savoir statistique.

+

+

+# Contexte

+

+> In this world, nothing is certain except death and taxes.

+>

+> Benjamin Franklin

+

+## Nature des données

+

+Les données statistiques traditionnelles (sondage ou recensement)

+sont produites pour informer. Cette finalité guide la conception

+de celles-ci, que ce soit au niveau du _design_, des concepts

+mesurés ou des retraitements post-collecte.

+La logique des données administratives est toute autre.

+Il s'agit de bases dont la finalité de construction est

+la gestion, c'est-à-dire l'enregistrement d'événements

+pour déclencher des actions (remboursement, paiement, etc.).

+

+Cet aspect transactionnel de la donnée adminstrative change ainsi

+le processus de production. Ces bases sont susceptibles d'être mises

+à jour à plusieurs échéances. D'abord, leur structure n'est

+pas figée dans le temps. Selon les événements à enregistrer, la

+structure du fichier de données évoluera. Par exemple, un nouveau

+crédit d'impôt amènera à l'ajout d'une catégorie dans les déclarations

+fiscales ce qui se traduira par un changement du fichier de gestion.

+A ce premier facteur d'évolution peut s'ajouter des changements à

+plus brève échéance. La collecte de données administratives est un

+processus vivant. Les données sont généralement modifiables

+au cours d'un exercice de gestion voire au-delà. La

+donnée n'est stabilisée qu'après plusieurs cycles de gestion

+et sa continuité, au niveau de l'unité statistique, ne va

+pas de soi. Par exemple, une entreprise changeant d'identifiant

+SIREN pour une raison

+liée à un changement administratif (par exemple une fusion)

+ne sera identifiable dans différents millésimes de données

+administratives que si on est en mesure de relier

+les différents identifiants sous lequel elle apparaît.

+

+Les données administratives peuvent provenir de plusieurs origines.

+Elles sont en premier lieu issues de processus de gestion interne à l’administration concernée.

+Par exemple, pour être en mesure de gérer les remboursements liés au système de

+protection sociale français, l'assurance maladie collecte et enregistre de nombreuses

+informations sur les actes médicaux. Cette collecte est automatisée grâce à la carte

+vitale et au système d'information de l'assurance maladie ou passe par des déclarations papiers

+normalisées.

+

+Une seconde source d'origine des données administratives sont les

+déclarations administratives[^2] [@riviere2018].

+Par exemple, les déclarations fiscales des ménages

+sont annuelles, avec un calendrier déterminé à l'avance (qui dépend du format, papier ou internet).

+Ce calendrier inclut d'ailleurs des possibilités allongées de retour sur la donnée fournie.

+L'obligation de certaines déclarations administratives

+se traduit par un pouvoir coercitif, pouvant prendre diverses formes, comme celle d’engager des poursuites.

+Ceci réduit le risque de non-déclaration ou de déclaration faussée mais ne l’annihile pas non plus.

+Selon la nature de la donnée, ces poursuites peuvent être pénales et les amendes non négligeables.

+L'existence de ces moyens coercitifs permet d'anticiper

+une information exhaustive sur la sous-population concernée par la donnée et

+honnête[^3].

+

+[^2]: Obligation est faite à un certain nombre d’entités (individus, entreprises, organismes publics) de fournir des informations respectant une certaine forme, selon certaines modalités (internet, papier) et temporalités.

+

+[^3]: Certaines enquêtes, reconnues d'utilité publique, comme l'enquête

+emploi, le recensement ou encore l'enquête ressources et conditions

+de vie (SRCV), sont obligatoires. Bien que cela permette d'avoir des taux

+de réponse élevés, cela n'assure pas un taux de 100%. Comme cela a été

+évoqué précédemment, le taux de réponse de SRCV

+est par exemple passé de 85 % à 80 % entre 2010 et 2019.

+Pour plus d'informations sur les enquêtes obligatoires, voir

+[la description du CNIS](https://www.cnis.fr/obligation-de-reponse/)

+et la liste des enquêtes concernées

+parmi [les enquêtes auprès des particuliers](https://www.insee.fr/fr/information/5390996).

+

+Si les données administratives sont devenues centrales dans le champ

+de la production statistique, c'est certes de par leur nature

+exhaustive mais aussi du fait de leur disponibilité à faible coût marginal.

+Les données administratives étant collectées et centralisées dans un

+système informatique à des fins de gestion, leur mise à disposition

+pour d'autres usages, s'il soulève certains enjeux sur lesquels

+nous reviendrons comme les questions de confidentialité,

+est marginalement peu coûteux. L'utilisation de ces données

+est ainsi une affaire d'opportunité: comme ces données

+sont disponibles et, sous un certain cadre juridique et technique,

+peuvent être ré-utilisables à d'autres fins, si elles fournissent

+une information de qualité, il est utile pour la production

+statistique de les exploiter.

+

+## Quelle différence avec les autres sources de données numériques ?

+

+Cette propriété des données administratives qu'est le coût

+marginal faible

+rapproche celles-ci des traces numériques.

+Les entreprises du numérique

+ont pu centrer leur modèle économique

+autour de la collecte et de la valorisation

+de données justement parce que la collecte

+de nouvelles informations est d'un coût marginal

+nul.

+Il en va de même avec les données de gestion: la collecte

+d'une information supplémentaire sur une unité ou d'une unité

+supplémentaire n'est pas coûteuse. Dans le monde de la donnée

+numérique, il est certes nécessaire d'engager des investissements

+pour être en mesure de collecter des données de manière massive

+ou mettre à l'échelle un processus de collecte devenu plus

+ambitieux que le plan initial mais la donnée marginale

+ne coûte pas très cher puisque, comme nous allons le voir,

+la collecte de celle-ci est reportée

+sur un tiers.

+

+Dès lors, la distinction entre données administratives et données

+numériques, telles qu'on peut formaliser le _buzzword_ "big-data",

+apparaît floue. La distinction correspond en premier lieu à l'origine des données.

+La donnée administrative est une donnée produite par

+la sphère administrative. Dans sa nature, son processus de

+production ne diffère pas de celui de la donnée privée. Dans les deux

+cas, un acteur effectue une activité (par exemple déclarer quelque chose)

+et cette activité va être transformée en information plus ou moins

+normalisée pour intégrer un système d'information et être stockée

+dans les serveurs d'un acteur centralisateur. Dans les deux cas,

+la personne dont la donnée a été collectée pourra éventuellement

+corriger l'information et/ou produire de nouvelles activités.

+

+La différence entre données administratives et données

+privée est ainsi plutôt une différence de degré que de nature.

+Les données administratives sont généralement collectées à plus faible fréquence.

+Par exemple, le rythme de collecte de nombreuses données est annuel pour

+correspondre aux rythmes des campagnes fiscales. Mais certaines sources sont

+à des rythmes plus fréquents. Par exemple la DSN, sur laquelle nous reviendrons,

+est collectée à un rythme mensuel. Certaines données sont mêmes enregistrées

+à des rythmes qui n'ont pas grand chose à envier avec les traces numériques

+du _big data_. Par exemple, les systèmes d'information SIVIC et SIDEP, respectivement

+celui de suivi des entrées à l'hôpital des personnes malades du Covid et celui des

+tests, étaient mis à jour quotidiennement. De même, le système

+d'information de l'assurance maladie est mis à jour en continu en fonction

+des nouveaux événements qui appellent un remboursement. Bien qu'on n'associe

+pas forcément les données administratives avec une collecte en temps réel, il

+ne s'agit ainsi pas d'un critère les discriminant vis à vis des traces numériques.

+

+La différence principale, peut-être, entre les données administratives

+et les données privées est que pour les premières, le champ est connu

+par le fait que celles-ci sont issues d'une collecte d'une population

+bien ciblée. Comme indiqué précédemment, comme la collecte de données

+administrative est souvent assortie de prérogatives légales, la population

+cible est généralement bien identifiée. Dans le monde de la donnée privée,

+comme c'est l'activité qui génère la donnée, le champ dépend de la base

+d'utilisateurs. Selon le type de données, celle-ci peut être plus ou

+moins large. Même parmi les données privées où les populations sont

+les plus larges, la couverture de la population n'est pas parfaite.

+Par exemple,

+les smartphones sont largement

+partagés dans la population. Néanmoins, cette

+technologie a un moindre taux de pénétration dans

+certaines population, notamment les plus

+agées. De plus, les opérateurs ont des parts de marché potentiellement

+hétérogènes (en fonction de critères d'âge ou territoriaux).

+Pour les opérateurs,

+il est difficile d'évaluer le champ de leur clientèle puisque cette

+information nécessite une enquête, et ainsi souffre de taux de réponse

+imparfaits ou de réponses incorrectes.

+Le champ est donc incertain

+puisqu'il n'est pas possible pour les producteurs

+de données privées d'apparier de manière automatique ces données

+avec les données administratives.

+Même s'il n'est pas toujours possible d'apparier des données administratives

+entre elles pour des raisons légales, le fait de fournir des informations

+communes dans différentes sources (état civil voire NIR)

+à un même acteur (l'Etat), facilite l'association entre les sources

+lorsque celle-ci est autorisée.

+

+Les 5V du big-data, initialement listés dans un rapport de MacKinsey,

+ne sont pas l'apanage des données privées.

+Il y a peut-être une différence de degré avec le big-data mais certainement pas

+de nature:

+

+- _Volume_: certaines données administratives représentent des volumes conséquents.

+La DSN représente ainsi plus d'1To de données par an ;

+- _Vélocité_: certaines données, notamment celles de l'assurance maladie, sont à haute fréquence ;

+- _Variété_: l'Etat collecte et exploite des données de natures très différentes ;

+- _Véracité_: les données collectées par l'Etat ne sont pas à l'abri d'erreurs mais ces dernières,

+qu'elles soient volontaires ou non, pouvant être couteuses, les données sont normalement de meilleure

+qualité que celles auto-déclarées sans contrôle ex-post ;

+- _Valeur_: les données collectées par l'Etat sont d'une grande valeur même si elles ne sont pas

+monétisées. La valorisation par l'Etat n'est bien-sûr pas individuelle mais la collecte de données

+qui sont ensuite agrégées permet de créer une statistique publique, qui est un bien public,

+sans valeur de marché mais avec une valeur sociale.

+

+

+Finalement, il y a peu de différence entre les données administratives

+et certaines données privées disponibles sous forme

+structurée. Par exemple, les données générées par les paiements par

+cartes bancaires (données du GIE CB)

+ne sont pas d'une nature très différente de données

+administratives. Comme celles-ci, il s'agit de données

+structurées issues d'un organisme centralisateur (le GIE CB)

+et mises à disposition consolidées pour la statistique publique.

+

+### Une donnée plus sensible

+

+L'aspect exhaustif, sur un certain champ d'unités et d'informations

+de gestion,

+des données

+administratives peut les rendre, au niveau individuel, assez sensibles.

+La question de la confidentialité et de la sensibilité

+des données fournie à l'administration n'est pas nouvelle,

+il s'agit de la raison d'être du secret statistique défini dans

+l'une des lois les plus importantes de la statistique

+publique, à savoir la loi de 1951.

+Les informations fournies dans le cadre de certaines enquêtes peuvent

+être sensibles (informations sur le revenu ou le patrimoine, la santé,

+l'appartenance à certains groupes sociaux...).

+Cependant, l'aspect non exhaustif des enquêtes rend plus difficile

+la réidentification après la phase d'anonymisation.

+Avec les

+données administratives, l'information fournie peut parfois être

+moins précise mais le caractère exhaustif de celles-ci fait

+qu'en combinant plusieurs sources de données la réindentification

+est facilitée.

+

+La question de la confidentialité est donc, au même titre que pour

+les données privées, devenu un enjeu dans le domaine des données

+administratives. Il est à noter que par rapport aux données

+privées cette question ne se pose pas au même niveau.

+Au niveau de la collecte de données, c'est-à-dire de la

+transformation d'une activité en donnée de gestion, là

+où l'utilisateur d'un service numérique bénéficie d'une

+relative liberté sur le choix des données collectées du fait du RGPD,

+ce n'est pas le cas pour l'utilisateur d'un service

+géré par l'Etat. Ce privilège de l'Etat s'appuie sur des

+décrets qui définissent des missions de service public.

+Cependant, au niveau des traitements mis en oeuvre,

+du stockage puis de la diffusion de la donnée,

+des conditions restrictives s'appliquent aussi

+à l'Etat.

+Exemple: SNDS.

+

+

+:::{.callout-note}

+

+## Cadre légal

+

+Cet encadré résume des éléments juridiques listés par @isnard2018.

+

+Les membres du service statistique public (SSP)

+bénéficient d’une disposition importante qui facilite énormément le travail du statisticien.

+Ce sont les seuls organismes à pouvoir mettre en œuvre l’article 7bis de la __loi de 1951__. Cet article leur permet de se faire communiquer, à des fins d’élaboration de statistiques publiques, tout fichier de gestion d’une administration ou d’une personne privée gérant un service public, dès lors que le Conseil national de l’information statistique a été consulté et que la demande émane du ministre chargé de l’économie (en pratique du directeur général de l’Insee). Cette mesure, insérée dans la loi du 7 juin 1951 par la loi du 26 décembre 1986, a permis une exploitation large des données administratives et ainsi un allègement de la charge de réponse aux enquêtes.

+

+L’utilisation de déclarations ou de sources administratives à des fins statistiques est préconisée par le code de bonnes pratiques de la statistique européenne dans le but d’alléger la charge statistique des déclarants. En France, ceci est rendu possible par la loi de 1951 relative à l’obligation, à la coordination et au secret en matière de statistique et a été réaffirmé récemment par la loi pour une République numérique (2016).

+

+:::

+

+

+## Processus de production

+

+Le processus de production de la donnée administrative est différent de

+celui de la donnée traditionnelle. La différence

+principale est la place

+centrale d'une autorité gestionnaire, qui centralise la donnée,

+dans le modèle de production des données administratives [@riviere2018].

+Cet acteur doit être distingué de l'administration qui exploite le

+flux, que ce soit à des fins de gestion ou d'exploitation statistique.

+

+La @tbl-autorites-centralisatrices donne quelques

+exemples de plateformes centralisatrices. Ces dernières ne se contentent

+pas de centraliser ou mettre à disposition la donnée, elles ont aussi

+en charge la normalisation de celle-ci à partir de systèmes d'informations

+divers. La normalisation est un enjeu majeur car elle seule permet

+l'exploitation des données: la collecte étant en général réalisée automatiquement

+via des auto-déclarations, les plateformes centralisatrices récupèrent

+des informations aux contenus hétérogènes.

+

+| Donnée | Autorité centralisatrice |

+|------|------|

+| DSN | Gip-MDS |

+| Données hospitalières | ATIH-10 |

+| SI gestion des eaux | SANDRE12 |

+

+: Exemples d'autorités centralisatrices [@riviere2018] {#tbl-autorites-centralisatrices}

+

+La @fig-dsn résume la place du GIP-MDS dans le processus de

+production de la DSN:

+

+::: {#fig-dsn}

+

+

+Schéma de la place du GIP-MDS dans la production de la DSN. Source: @Humbert2018.

+:::

+

+## Usage de la donnée administrative

+

+L'usage de ces données est de deux nature: l'usage à des fins

+de gestion (la finalité pour laquelle elles sont construites)

+et l'usage à des fins d'analyse (la finalité fortuite).

+Ces peut aller au-delà de l’administration concernée.

+Par exemple,

+la déclaration sociale nominative n'est

+pas utilisée exclusivement par le Ministère du Travail mais aussi

+par la DGFIP, les institutions de prévoyance, les organismes de retraite, l’Acoss, pour leurs propres usages de gestion ; les données de SIRENE servent de référence, de preuve pour les entreprises, elles sont utilisées par les chambres de commerce et d’industrie ou par les greffes des tribunaux de commerce [@riviere2018].

+

+### Un usage accru pour apparier des sources

+

+Certaines sources administratives ont un rôle

+particulier dans le processus de production

+statistique car elle permettent d'identifier

+des unités statistiques dans plusieurs sources.

+Le Répertoire national d’identification des personnes physiques (RNIPP),

+le répertoire Sirene pour les entreprises

+ou encore XXX pour les logements, sont

+des sources qui permettent de relier des unités

+statistiques entre plusieurs sources.

+On parle d'appariements pour désigner ce type

+d'opérations où plusieurs sources de données

+sont associées grâce à une information

+commune. Cela peut se faire sur la base d'une

+information exacte, en général un identifiant

+unique fourni par un des référentiels,

+ou de manière floue à partir d'informations

+non uniques mais qui, combinées, peuvent aider

+à identifier une unité (nom, raison sociale d'une

+entreprise, adresse, etc.).

+

+Ces répertoires administratifs

+sont ainsi des sources

+devenues centrales dans le processus

+de production statistique. Ils permettent

+d'enrichir d'autres sources administratives,

+ou des enquêtes, d'informations administratives.

+Ces dernières peuvent ainsi permettre d'alléger

+certains questionnaires d'enquêtes ou de

+concentrer ceux-ci sur des informations qui

+ne sont pas disponibles dans les sources

+administratives.

+

+:::{.callout-note}

+## Le CSNS

+Un enjeu fort existe autour de la production d'un [code statistique non signifiant](https://www.insee.fr/fr/information/5388962) (CSNS) pour les besoins de mise en œuvre de traitements à finalité de statistique publique impliquant le numéro de sécurité sociale (NIR) ou des traits d’identité, en particulier les appariements au sein du Service statistique publique. La version finale est prévue pour la fin de l'année 2022.

+:::

+

+### Un changement de la place de l'analyste de la donnée

+

+Cette situation change la place du statisticien

+dans le processus de production de la statistique officielle.

+Il convient de transformer en aval les données pour répondre

+aux besoins de l'analyse statistique.

+Cela implique un contrôle qualité ex-post, éventuellement

+un travail de reconstitution et de consolidation.

+

+Cette situation change également la place des chercheurs dans

+le processus de production de la donnée. Comme le statisticien,

+le chercheur n'est plus associé à l'amont de la production de données.

+Cependant celui-ci est, généralement, encore plus en aval que le statisticien public.

+Il reçoit les données généralement consolidées, anonymisées et éventuellement appariées

+entre différentes sources. A cet égard, les données administratives

+scandinaves sont parmi les données les plus utilisées par les chercheurs sur

+le marché du travail car elles constituent une source depuis longtemps

+centralisée et mise à disposition de manière anonymisée.

+

+

+## En conclusion, quels avantages et inconvénients ?

+

+La production et l'usage de données administratives

+se sont généralisés. La numérisation croissante

+de l'économie est amené à confirmer cette

+tendance. L'utilisation par la statistique

+publique de données privées, sous leur forme

+structurée, n'est qu'un prolongement de cette

+dynamique. Ces dernières permettent d'enrichir

+l'information dont dispose l'administration

+avec des informations collectées dans

+le cadre d'activités économiques détachées de l'administration.

+

+Les avantages des données administratives sont multiples.

+En premier lieu, la collecte automatisée de celle-ci,

+associée à un pouvoir public coercitif, permet d'atteindre

+sur un champ d'unités statistiques bien définies (usuellement

+par le biais d'un décret), une forme d'exhaustivité.

+Cette dernière permet de construire des statistiques plus

+fines. Si aujourd'hui il est possible pour des chercheurs

+de zoomer sur le très haut de la distribution de revenu (voir les travaux de Piketty),

+c'est parce que l'aspect exhaustif des données permet

+d'avoir des groupements suffisamment nombreux pour assurer la confidentialité

+de ces groupes.

+

+Une fois payé le coût d'investissement pour automatiser la production statistique

+à partir de données de gestion, les données administratives

+ouvrent la voie à la production à plus haute fréquence

+de statistiques officielles.

+La production annuelle ou infra-annuelle de statistiques

+n'est possible qu'avec un nombre restreint d'enquêtes - dans la plupart des cas,

+les résultats d'enquêtes sont connus avec du retard.

+La publication quotidienne par le service statistique du Ministère de la Santé

+(la DREES) et Santé Publique France d'indicateurs sur la pandémie

+est un bon exemple de l'intérêt de ces données. Ces dernières ont permis

+un suivi très fin par la puissance publique mais aussi par la société civile des

+évolutions de l'épidémie.

+

+Un autre avantage des données administratives est que les informations

+qui sont disponibles dans celles-ci sont certes diverses (nous reviendrons

+sur cela dans le prochain chapitre à travers quelques exemples) mais elles sont,

+sur certains champs, très fiables. Elles souffrent normalement moins de biais

+de réponses même si elles n'en sont pas exemptées (les déclarations erronées

+à l'administration fiscale existent, qu'il s'agisse d'un comportement volontaire

+ou non).

+

+Ces données soulèvent de nouveaux défis pour la statistique publique.

+En premier lieu, elles amènent à redéfinir le rôle du métier

+dans le processus de production de la donnée. Ceci est vrai dans le

+monde de la donnée administrative mais aussi dans le domaine des

+données privées.

+Comme l'utilisateur de données ne contrôle pas le champ ou la

+définition du concept mesuré, c'est le concentrateur, cet acteur

+dont l'activité est spécialisée autour de la collecte et de

+la gestion du flux, qui intervient à cet étape. Il peut ainsi

+être amené à faire évoluer le champ, la définition du phénomène

+mesuré ou encore le formulaire sans

+que l'analyste de données n'ait son mot à dire.

+Pour reprendre l'exemple des données quotidiennes, l'apparition de

+variants à plusieurs reprises a amené à des évolutions, parfois

+sans préavis, du type de donnée collectée, enregistrée.

+Les données déjà collectées n'ayant pas vocation à intégrer

+ces informations qui n'avaient pas de sens au moment de la collecte,

+c'est à l'analyste de données de faire des choix méthodologiques pour

+reconstruire une série cohérente.

+Le statisticien, parce qu'il intervient plus en aval, change donc de rôle.

+Les données administratives n'étant pas construites pour mesurer un

+phénomène qui a du sens pour le statisticien public (ou l'analyste de la

+donnée privée), c'est à lui de reconstruire à partir de l'information

+de gestion la réalité statistique derrière [@salgado-20]. Le travail

+de l'analyse de données va au donc au delà de la simple reconstruction

+de variable, ou du contrôle qualité, il est également nécessaire

+de réfléchir au concept mesuré pour ne pas construire d'"artefact",

+au sens de Bourdieu.

+Cette problématique se pose, de la même manière,

+à la recherche et à l'exploitation

+de données privées.

+

+

+# References

+

+::: {#refs}

+:::

diff --git a/administratives_exemples.qmd b/administratives_exemples.qmd

new file mode 100644

index 0000000..700af1d

--- /dev/null

+++ b/administratives_exemples.qmd

@@ -0,0 +1,145 @@

+---

+title: "Quelques exemples approfondis de données administratives"

+---

+

+# Exemples

+

+4 exemples de nature différente:

+

+- la DSN: base de gestion transmise à l'Insee et la DARES pour la production ;

+- Sirene: répertoire géré par l'Insee, utilisé par d'autres acteurs ;

+- Fidéli: agrégation et mise en cohérence de plusieurs sources ;

+- SNDS: mise en cohérence de données de gestion hospitalières et de l'assurance maladie, enjeu encore plus fort de confidentialité ;

+

+:::{.callout-note}

+## Les autres répertoires de la statistique publique

+

+- Filosofi (Fichier localisé social et fiscal): répertoire de synthèse des sources fiscales ;

+- La Base permanente des équipements (BPE): répertoire d'équipements et services.

+:::

+

+## La DSN

+

+:::{.callout-note}

+## Les DADS et la DSN

+

+Descriptions sur le site de l'Insee de la [Déclaration annuelle de données sociales](https://www.insee.fr/fr/metadonnees/source/serie/s1163) (DADS) et de la [Déclaration sociale nominative](https://www.insee.fr/fr/information/3647025?sommaire=3647035) (DSN).

+:::

+

+La Déclaration sociale nominative est aujourd'hui le mode d'échanges de données sociales des entreprises vers l'administration, et concerne toutes les entreprises du secteur privé. Elle résulte d'un projet de simplification administrative qui s’est étalé sur près de dix ans : la collecte des données est adossée au processus générateur de la collecte des cotisations sociales, c’est-à-dire au processus de paie [@Humbert2018]. En plus de réduire la charge imposée aux entreprise, la DSN garantit une bien meilleure qualité et l'exhaustivité de l’information recueillie.

+

+### Avant la DSN

+

+Les déclarations sociales font partie des tâches administratives historiquement imposées aux entreprises françaises. La déclaration sociale nominative (DSN), née à la fin des années 2000, a été instituée par la loi de simplification du 22 mars 2012, dite loi Warsman. Elle est obligatoire pour toutes les entreprises depuis début 2017.

+

+Les déclarations sociales reposaient auparavant sur des formulaires Cerfa dont le contenu était fixé par les textes fondant la collecte des données utiles aux organismes de protection sociale et à l’administration pour l’exercice de leurs missions. Non seulement les déclarants étaient amenés à fournir plusieurs fois la même information, mais ils devaient surtout fournir une information qui n’était pas naturellement produite par leur système de gestion, ce qui était source d’incohérences et d’erreurs dans les déclarations. La DSN met en œuvre une logique fondamentalement différente : elle s’approche au plus près du fait générateur des rémunérations et cotisations sociales dans le domaine de la protection sociale, la paie. Elle repose sur un modèle unique de cette dernière et un échange de données primaires de gestion entre l’émetteur, qui fait la paie, et tous les organismes et administrations qui ont besoin de ces données sociales pour recouvrer des cotisations et servir des droits. Elle opère donc un déplacement de la charge de traitement des données de l’amont (l’entreprise déclarante) vers l’aval.

+

+La DSN se fait au niveau de chaque établissement avec un principe clé : chaque salarié doit apparaître dans la déclaration. Cette dernière se fait de manière mensuelle et reflète la paie du mois $M-1$, avec certaines possibilités de correction.

+

+::: {#fig-image-nb}

+

+

+Schéma explicatif des changements apportés par la DSN. Source : @Humbert2018.

+:::

+

+### Avantages

+

+La DSN présente de nombreux avantages. Elle constitue une source unique et cohérente entre administrations. Avec la DSN, on est sûr que les employeurs et les salariés sont identifiés de la même façon quel que soit l’organisme destinataire de l’information [@Renne2018].

+

+Elle a aussi permis une forte réduction des charges pour les entreprisess ("dites le nous bien une seule fois"). Par exemple, depuis janvier 2018, les entreprises n’ont plus obligation de fournir leur effectif salarié de fin de période, celui-ci pouvant être recalculé directement par les organismes destinataires à partir des informations individuelles transmises sur les salariés [@Renne2018].

+

+La fréquence mensuelle de transmission des données permet un meilleur suivi des changements infra-annuels. Auparavant, les entreprises transmettaient des données multiples à diverses échéances et à différents organismes, globalisées par établissement.

+

+La DSN n’a pas vocation à servir un besoin spécifique, mais au contraire à couvrir différents usages. Les systèmes d'informations des administrations utilisatrices (Insee, DARES, Pole Emploi, etc.) reçoivent une liste spécifique de données, fixée par arrêté selon leurs missions et se sont synchronisés au fur et à mesure de l’élargissement du périmètre. Depuis 2019, la DSN est le support du prélèvement à la source pour les salariés.

+

+### Challenges

+

+Plusieurs challenges se posent au moment d'utiliser les données issues de la DSN à des fins statistiques. Tout d'abord, les données sont complexes, ce qui implique un certain coût d'entrée. Elles sont aussi volumineuses (environ 1To par an, sans la fonction publique) et leur traitement requiert ainsi des ressources informatiques conséquentes et des outils adaptés. On constate bien un transfert d'une partie de la charge des entreprises vers les systèmes d’information en aval.

+

+Autres challenges liés à l'exploitation statistique:

+

+- parvenir à relier les concepts administratifs à des réalités économiques ;

+- éviter les "artefacts" au sens de Bourdieu.

+

+## Sirene

+

+Le Système national d’identification et du répertoire des entreprises et de leurs établissements (Sirene) est un répertoire administré par l’Insee qui centralise de l'information sur chacun des 32 millions d'établissements (dont 13 millions d'établissements actifs) existant en France. En particulier, il attribue un numéro SIREN aux entreprises, organismes et associations ainsi qu'un numéro SIRET aux établissements de ces entités.

+

+L’utilité du numéro SIRET est multiple. S’il constitue avant tout la preuve juridique de l’existence d’un établissement, il permet également d’effectuer un certain nombre de démarches commerciales et administratives.

+

+Ainsi, il sert à :

+

+- Émettre des factures, mais aussi des documents commerciaux. En effet, il est obligatoire de faire apparaître le numéro sur chacun de ces documents. En outre, si l’entreprise à un site internet, le numéro doit apparaître dans les mentions légales ;

+- Obtenir des informations officielles sur les sociétés. Grâce au SIRET, tout prestataire ou client peut vérifier la fiabilité des données que l’entreprise lui fournit, via une recherche sur internet notamment ;

+- Prouver l’existence légale de la compagnie. Ce numéro permet en effet de l’identifier auprès de ses clients, prestataires, co-contractants et par l’administration fiscale ;

+- Produire des statistiques à partir de la base Sirene et du numéro SIRET. En effet, ces deux éléments donnent accès à des informations capitales que l’INSEE peut réutiliser et analyser.

+

+Pour la statistique publique, Sirene met à disposition des utilisateurs un code APE (pour activité principale exercée) choisi dans la Nomenclature d'activité française (NAF) pour chaque établissement (APET) et pour chaque entreprise (APEN), ainsi que sa localisation, sa catégorie juridique, son effectif salarié et l’historique des mouvements (création, cessation, etc.). Le répertoire SIRENE est aussi la base de référence pour toutes les études et enquêtes statistiques sur les entreprises.

+

+## Fidéli

+

+Le Fichier démographique sur les logements et les individus (Fidéli) est une base annuelle exhaustive de données statistiques sur les logements et de leurs occupants. Fidéli est en réalité un assemblage raisonné de données administratives conçu pour répondre à des finalités en matière de statistiques démographiques.

+

+Cet appariement met en regard:

+

+- des données d'origine fiscale: fichier de la taxe d'habitation, fichier des propriétés bâties, fichiers d'imposition des personnes et fichier des déclarations de revenus. Ces données sont de nature démographique pour les personnes et la structure des ménages, ainsi que sur les revenus perçus au sein des foyers;

+- des données contextuelles pour décrire les adresses: coordonnées, appartenance à des mailles géographiques (IRIS, quartiers de la ville), etc. ;

+- des informations sur les agrégats de revenus déclarés et les montants de prestations sociales reçues.

+

+Fidéli fournit des possibilités d'études poussées sur des sujets extrêmement variés et à des échelles géographiques fines. Des exemples de projets de recherche récents :

+

+- Dynamiques de l’organisation du territoire et des inégalités spatiales en milieux urbains pollués ;

+- Caractérisation spatiale de la vulnérabilité sociale à la hausse des températures en milieu urbain ;

+- Evaluation de l’impact de la majoration de la taxe d’habitation sur les résidences secondaires...

+

+## SNDS

+

+Le Système national des données de santé (SNDS) est un entrepôt de données médico-administratives pseudonymisées couvrant l'ensemble de la population française et contenant l'ensemble des soins présentés au remboursement. Le SNDS peut être vu comme un appariement des grandes bases médico-administratives nationales, notamment :

+

+- les données de l'assurance maladie (base SNIIRAM) ;

+- les données des hôpitaux (base PMSI) ;

+- les causes médicales de décès (base du CépiDC de l'Inserm).

+

+Le SNDS est un dispositif quasiment sans équivalent en Europe ou dans le monde. Il contient un flux annuel de 1,2 milliards de feuilles de soins, 11 millions de séjours hospitaliers et 500 millions d'actes (plus de 3000 variables) qui représentes 450 To de données.

+

+Une des grandes forces du SNDS est qu'il fait le lien entre médecine de ville et médecine hospitalière, ce qui permet de travailler sur les parcours de soin complets des patients pour des études, recherches ou évaluations présentant un caractère d'intérêt public. Les finalités autorisées pour les traitements sont :

+

+- l'information sur la santé et l'offre de soins ;

+- l'évaluation des politiques de santé ;

+- l'évaluation des dépenses de santé ;

+- l'information des professionnels de santé sur leur activité ;

+- la veille et la sécurité sanitaires ;

+- la recherche, les études, l'évaluation et l'innovation en santé.

+

+:::{.callout-note}

+## Mise à disposition des données

+Créé par la Loi du 24 juillet 2019 relative à l’organisation et la transformation du système de santé, le Health Data Hub est un groupement d’intérêt public qui associe 56 parties prenantes, en grande majorité issues de la puissance publique (CNAM, CNRS, Haute Autorité de santé, France Assos Santé, etc.). Le Health Data Hub est en charge de mettre en œuvre les grandes orientations stratégiques relatives au Système National des Données de Santé fixées par l’Etat.

+

+L'offre du Health Data Hub s'articule autour de 4 enjeux stratégiques:

+

+- mettre en valeur le patrimoine des données de santé, en appuyant leur collecte, leur standardisation et leur documentation, en fournissant un hébergement à l’état de l’art sécurisé et un accompagnement dans la mise en conformité RGPD ;

+- faciliter l'usage des données, en proposant un catalogue de données documentées, ainsi qu'une plateforme d'analyse et des outils à l’état de l’art ;

+- protéger les données et les citoyens, en garantissant un très haut niveau de sécurité à travers une démarche éthique de protection des données et de transparence ;

+- innover avec l'ensemble des acteurs, en développant des partenariats académiques et industriels, et en appuyant la dynamique de développement d’outils open source et de l’open data.

+:::

+

+:::{.callout-note}

+## Confidentialité et données de santé

+Pour protéger l'identité des patients et garantir la confidentialité des données, chaque patient est repéré dans l'ensemble du SNDS par un pseudonyme, obtenu par l'application au NIR d'un procédé cryptographique irréversible appelé FOIN. Les données du SNDS sont conservées pour une durée totale de 20 ans, puis archivées pour une durée de 10 ans.

+

+L'accès aux données du SNDS et leur analyse ne peut se faire que dans un cadre d'hébergement très restrictif respectant le référentiel de sécurité du SNDS, afin de garantir la traçabilité des accès et des traitements, la confidentialité des données et leur intégrité.

+:::

+

+### L'EDP-Santé

+

+L'EDP-Santé est un enrichissement des données de l’[échantillon démographique permanent](https://www.insee.fr/fr/metadonnees/source/serie/s1166) (EDP) avec des informations issues du SNDS sur les années 2008-2022. Ce traitement a fait l’objet d’une autorisation de la CNIL et s’inscrit dans le cadre du règlement général sur la protection des données (RGPD), ainsi que la loi relative à l’informatique, aux fichiers et aux libertés (n° 78-17 du 6 janvier 1978 modifiée). Constitué dans le cadre de la stratégie nationale de santé 2018-2022, les données ne sont exploitables que par les personnes habilitées au sein de la DREES et sont conservées pour une période de 5 ans.

+

+L'EDP-Santé contient :

+

+- les données issues de l’EDP concernent l’état civil, la situation familiale, la vie professionnelle (diplôme, situation professionnelle, données relatives à l’activité salariée) et des informations d’ordre économique (revenus, situation fiscale) ;

+- les données issues du SNDS sur les recours aux soins et les données issues des certificats de décès.

+

+# References

+

+::: {#refs}

+:::

diff --git a/geolocalized_data.qmd b/geolocalized_data.qmd

new file mode 100644

index 0000000..5ce5800

--- /dev/null

+++ b/geolocalized_data.qmd

@@ -0,0 +1,163 @@

+---

+title: "Données géolocalisées"

+bibliography: references.bib

+---

+

+### Introduction

+

+Disposer de données géolocalisées pour produire de la statistique publique est un besoin qui se fait de plus en plus fort. Pour cause, un intérêt croissant est accordé aux caractéristiques spatiales des phénomènes que la statistique publique a pour rôle de décrire. Le comité d'experts des Nations Unies sur la gestion de l'information géospatiale mondiale (`UN-GGIM`) a d'ailleurs *reconnu l’importance cruciale d’intégrer les informations géospatiales aux statistiques et aux données socio-économiques et le développement d’une infrastructure statistique géospatiale*.

+

+La production et la diffusion accrue de données géolocalisées dépasse le cadre de la statistique publique.

+La généralisation

+de traces numériques géolocalisées (données mobile, GPS, localisation d'adresses IP...) a entraîné une

+multiplication des acteurs valorisant des données spatiales. Certains acteurs de l'écosystème

+de la donnée sont spécialisés dans la collecte ou la valorisation de sources géolocalisées

+collectées par d'autres.

+

+Un premier apport fondamental des données géolocalisées

+est qu'elles permettent de calculer des indicateurs avec

+une granularité spatiale plus fine que les découpages administratifs ou historiques classiques.

+Cette approche permet d'éclairer des phénomènes socio-économiques locaux comme les problématiques

+de mixité [@galiana2020segregation].

+L'Insee met à disposition en _open-data_ des données très fines sur une grande variété

+de facteur. Les sites officiels [geoportail](https://www.geoportail.gouv.fr/) et

+[statistiques-locales.insee.fr](https://statistiques-locales.insee.fr) ou encore

+les sites faits par des tiers comme [celui d'Etienne Côme](https://www.comeetie.fr/galerie/francepixels/)

+ou [hubblo](https://www.hubblo.fr/) permettent d'explorer la richesse des sources fines

+mises à disposition.

+Pour désigner les sources les plus fines, on parle de données carroyées, publiées sur des carreaux pouvant aller de 200 mètres à plusieurs kilomètres de côté (voir @fig-carroyees). Une telle granularité permet de capter certains phénomènes démographiques ou socio-économiques qui ne sont pas détectables au niveau de l'IRIS ou de la commune[^1].

+

+[^1]: Le [projet `gridviz`](https://github.com/eurostat/gridviz) porté par `Eurostat` vise à proposer un

+outil facilitant la construction de mosaiques agrégées à partir de données spatiales.

+

+::: {#fig-carroyees}

+{ width=70% }

+

+Carte des densités de population sur des carreaux de largeur d'un kilomètre à Lyon et ses alentours en 2017 (calculées à partir de Filosofi). Source : [géoportail](https://www.geoportail.gouv.fr/donnees/densite-de-population).

+:::

+

+### Les données publiques géolocalisées

+

+Plusieurs grands répertoires de données de l'Insee sont ainsi géolocalisés aujourd'hui :

+

+- `Filosofi` (pour __Fichier localisé social et fiscal__) est un fichier de synthèse de sources fiscales (déclarations de revenus des ménages, taxe d'habitation, fichier d'imposition des personnes) enrichi par les données sur les prestations sociales fournies par les organismes sociaux, pour un peu plus de 26 millions de ménages fiscaux en France. Les résidences des ménages y sont géolocalisées ;

+- `Fidéli` (pour Fichier démographique sur les logements et les individus) peut se définir comme une base annuelle exhaustive de données statistiques sur les logements - qui sont géolocalisés - et de leurs occupants ;

+- La `Base Permanente des Equipements (BPE)` est une source qui fournit le niveau de services rendus à la population sur un territoire, en répertoriant un large éventail d'équipements et de services accessibles au public sur l'ensemble de la France au 1er janvier de chaque année. La plupart des types d'équipement (commerce, services, santé, etc.) sont géolocalisés dans la base accessible en *open data* ;

+- Les établissements du répertoire `Sirene` sont géolocalisés (hors Mayotte) et ces données sont mises à disposition des utilisateurs en *open data*. La géolocalisation des établissements actifs de 200 salariés ou plus a été systématiquement vérifiée par des gestionnaires de reprise de géolocalisation, ainsi que celle des établissements de 20 à 199 salariés pour lesquels la géolocalisation automatique est incertaine ;

+- Le `Recensement de la Population` conduit aujourd'hui à une publication de statistiques à la maille des IRIS. Une première diffusion de données carroyées à partir du recensement suite à une phase de géolocalisation est prévue pour 2024.

+

+En général, la géolocalisation est réalisée par une combinaison d'un appariement avec un référentiel d’adresses géolocalisées construit à partir du `Répertoire d’Immeubles Localisés (RIL)` pour les besoins du Recensement de la Population dans les communes de plus de 10 000 habitants, et de la géolocalisation des parcelles cadastrales. Ce sont ainsi ces deux répertoires administratifs qui permettent de géolocaliser de nombreuses autres sources. Une reprise manuelle peut être faite dans les cas où la géolocalisation n'est pas possible ou s'est faite avec un faible niveau de confiance.

+

+L'appariement entre les grands répertoires géolocalisés et d'autres sources peut donner naissance à des bases de données extrêmement riches et ainsi à des études de phénomènes socio-économiques à des échelles spatiales très faibles. Par exemple, @andre-21 constituent une base exhaustive rassemblant les caractéristiques des ménages et la description détaillée de leur patrimoine immobilier, à partir de différentes sources administratives (le cadastre, le fichier Fidéli, les revenus fiscaux et sociaux, les transactions immobilières et des données sur les sociétés civiles immobilières). Cette base permet d'analyser finement la concentration de la propriété immobilière en fonction du niveau de vie ou encore le profil redistributif de la taxe foncière (part de cette taxe dans le revenu disponible en fonction de ce dernier).

+

+:::{.callout-note}

+Les données géolocalisées sont relativement récentes à l'Insee et ne sont pas encore exploitées à leur plein potentiel. Preuve de la reconnaissance de ce dernier, un *Manuel d'analyse spatiale* [@feuillet-18] a été publié pour former les agents de l'Institut (entre autres) à la fois sur la théorie et l'application pratique avec `R` de méthodes d'analyse spatiale.

+:::

+

+:::{.callout-note}

+Une attention particulière doit être portée lors de la publication d'informations à un niveau fin à la protection de la vie privée et au respect du secret statistique. En effet, les réglementations européennes et nationales interdisent la diffusion de données permettant la réidentification de l'identité de ménages (ou d’entreprises) concernés. Or c'est un risque qui devient important dès lors que l'on publie des indicateurs à une échelle territoriale fine.

+

+Pour garantir la confidentialité au moment de la publication d'indicateurs, une possibilité est de contrôler les cellules au sein desquelles les calculs ont été faits pour identifier des cellules à risque, typiquement des cellules avec une population faible. Ces cellules à risque peuvent être fusionnées avec d'autres cellules ou subir d'autres traitements spécifiques (imputation de l'indicateur d'intérêt par exemple) pour diminuer le risque de réidentification [@feuillet-18].

+

+Une autre approche consiste à travailler en amont du calcul des indicateurs à publier. On associe à chaque observation un niveau de risque qui représente sa probabilité d'être réidentifié et qui dépend des caractéristiques des observations voisines. Les observations présentant un risque élevé peuvent ensuite subir un traitement spécifique, comme la permutation de leurs caractéristiques avec d'autres observations (méthodes de *swapping*).

+:::

+

+De nombreux acteurs privés collectent des données géolocalisées, en général en grande quantité, qui ont un fort potentiel pour la statistique publique. Dans le cadre de partenariats, l'Insee peut obtenir des accès temporaires (parfois indirects) à de telles données.

+

+### Données de téléphonie mobile

+

+Les données de téléphonie mobile en sont un bon exemple. On distingue en général 2 types de données de téléphonie mobile :

+

+- Les *Call Detail Records* (CDR) qui sont générés lors des communications actives d'un utilisateur à travers son téléphone mobile (appel, envoi de SMS, etc.);

+- Les données de signalisation passive qui sont collectées par les opérateurs principalement à des fins d'optimisation et de surveillance de leurs réseaux. Ces données de signalisation sont caractérisées par une fréquence temporelle bien supérieure à celle des données CDR.

+

+Ces deux types de données contiennent la même information spatiale : chaque observation contient des informations sur l'antenne radio avec laquelle le téléphone est en communication. Les données CDR permettent de produire des statistiques intéressantes sur les populations présentes et les déplacements de la population. Par exemple, @galiana-20 observe à partir de comptages issus des données CDR que la répartition de la population sur le territoire s’est significativement modifiée à la mise en place du confinement en mars 2020, au début de la pandémie de Covid-19 (voir @fig-confinement-deconfinement). Pendant le confinement, la population a davantage passé la nuit dans son département de résidence qu’avant le confinement. Au moment du déconfinement, les mêmes données de CDR indiquent que les mouvements de population sur le territoire ont repris partiellement, le sûrcroit de population se trouvant dans son département de résidence diminuant de moitié par rapport à la période de confinement.

+

+::: {#fig-confinement-deconfinement}

+{ width=80% }

+

+Évolution du nombre de personnes présentes dans les départementents métropolitains lors du confinement par rapport à la période antérieure (à gauche) et lors du déconfinement par rapport au confinement (à droite).

+:::

+

+Les données de signalisation permettent d'aller plus loin, par exemple en estimant des populations présentes avec une fréquence temporelle élevée [@ricciato-20]. Pour un maillage territorial donné, par exemple des carreaux de 200 mètres de côté, les opérateurs téléphoniques peuvent modéliser leur réseau de manière à estimer la probabilité qu'un téléphone se trouvant au sein d'un carreau $i$ soit détecté dans une cellule (aire couverte par une antenne) $j$. Ceci permet d'avoir une estimation du lieu où se trouvent tous les téléphones en lien avec le réseau quasiment en continu. En repondérant les nombres de téléphones estimés dans chaque tuile en fonction du nombre du nombre de téléphones considérés comme résidant dans chaque tuile et la population effectivement résidente de chaque tuile (obtenue grâce aux données fiscales géolocalisées), il est possible d'avoir une estimation en temps réelle de la population présente pour le maillage territorial choisi.

+

+La @fig-france-pops et la @fig-paris-pops illustrent ces estimations des variations de densité de population présente, heure par heure dans une même journée et jour par jour dans une même semaine, respectivement en France métropolitaine et à Paris et ses alentours. Même s'il faut prendre ces résultats avec précaution au vu de la simplicité de la méthodologie adoptée, on constate des tendances intéressantes :

+

+- On peut observer les variations de populations présentes intra-journalières dues aux mouvements des habitants des banlieues d'agglomérations qui travaillent en centre-ville. La population présente a tendance à être élevée dans la périphérie des villes la nuit, où elle diminue à partir de 9 heures du matin et jusqu'au soir au profit des centres-villes ;

+- Lorsqu'on regarde Paris et ses alentours avec une granularité spatiale plus fine, les variations de populations présentes intra-journalières discriminent les zones avec une forte activité touristique, économique et de loisirs des zones résidentielles ;

+- Les variations de populations présentes à l'intérieur de la semaine montrent que les villes (et en particulier Paris) se vident en partie pendant les week-ends, au moment où les régions côtières et montagneuses ont tendance à accueillir des visiteurs. À Paris, certaines zones voient leur population présente augmenter la nuit lors des week-ends, ce qui suggère une activité nocturne ou des nuitées touristiques.

+

+::: {#fig-france-pops}

+

+  +

+  +

+

+

+Estimation des variations de densité de population présente (nombre de personnes présentes par kilomètre carré), heure par heure dans une même journée (à gauche) et jour par jour dans une même semaine en France métropolitaine.

+:::

+

+::: {#fig-paris-pops}

+

+  +

+  +

+

+

+Estimation des variations de densité de population présente (nombre de personnes présentes par kilomètre carré), heure par heure dans une même journée (à gauche) et jour par jour dans une même semaine à Paris et ses environs.

+:::

+

+:::{.callout-note}

+L'utilisation de données de téléphonie mobile pour la production de statistiques publiques pose des questions :

+

+- **Questions sur la qualité** : les données disponibles ne concernent qu'un sous-champ de la population, par exemple les clients d'un opérateur en particulier, ce qui engendre en général des biais de sélection. Dès lors, il est nécessaire d'évaluer la représentativité de ce sous-champ par rapport à la population générale pour s'assurer de la validité (partielle) des résultats;

+- **Questions sur la perennité** : les données viennent de tiers privés et l'Insee n'a donc aucun contrôle sur des possibles changements de format ou de méthode de collection des données. Dans ce contexte, il n'y a pas de garantie que les indicateurs restent comparables au cours du temps.

+- **Questions d'éthique** : avant d'utiliser ces données personnelles, il faut s'assurer que l'usage qui en est fait est proportionné et que la production statistique qui en résulte a une valeur ajoutée pour la population.

+- **Questions légales** : les aspects légaux autour des données personnelles sont aussi à prendre en compte, en lien d'ailleurs avec les questions d'éthique et les questions sur la pérennité. Aujourd'hui la législation européenne et son application dans la loi française ne sont pas favorables à l'utilisation de données téléphoniques de signalisation pour la statistique publique. Même si elles venaient à le devenir, il n'y a aucune garantie qu'on ne revienne pas quelques années après à la situation actuelle.

+:::

+

+### Données de réseaux sociaux

+

+Les réseaux sociaux sont une autre source privée d'informations parfois géolocalisées. Les données issues de réseaux sociaux ont potentiellement des applications intéressantes pour la statistique publique :

+

+ - En complément des données de téléphonie mobile, elles peuvent participer à l'estimation de populations présentes en temps réel, avec un apport particulier pour le tourisme. Pour cause, les touristes sont souvent absents des données de téléphonie mobile et ont tendance à être très actifs sur les réseaux sociaux ;

+ - Elles peuvent servir à estimer le niveau de bien-être de la population à partir de méthodes d'analyse de sentiment ;

+ - Elles peuvent servir à analyser l'opinion publique à propos de sujets ou d'évènements particulier. Par exemple, `CBS` (INS des Pays-Bas) utilise un indicateur de sentiment calculé à partir de données issues de réseaux sociaux pour complémenter un indicateur de confiance des consommateurs lui calculé à partir de données d'enquête [@brakel-17].

+

+Aujourd'hui plusieurs réseaux sociaux fournissent des interfaces pour accéder à leurs données. Par exemple, `Twitter` propose une API qui permet de récupérer des tweets à partir de requêtes simples à construire. Il est ainsi possible de récupérer tous les tweets contenant un ou plusieurs mots clés, en excluant les retweets et les tweets sans information de géolocalisation.

+Tous les _tweets_ ne contiennent pas d'information sur la position de l'appareil utilisé au moment de l'envoi : il faut que l'utilisateur ait activé cette fonctionnalité. On peut avec de telles requêtes de connaître la position et l'heure exactes de l'envoi des tweets - géolocalisés - portant sur un sujet.

+

+:::{.callout-note}

+Des forts biais de sélection peuvent exister lorsque l'on exploite les données de réseaux sociaux.

+Dans le cas de `Twitter` par exemple, les personnes qui tweetent, et a fortiori les personnes qui tweetent en partageant leur localisation ne constituent a priori pas un échantillon représentatif de la population générale. C'est encore davantage le cas sur un sujet en particulier.

+A priori, les gens qui communiquent sur ce sujet sont plus souvent concernés directement que la population générale.

+

+Pour publier des indicateurs relevant de la statistique publique et calculés entièrement à partir de données de réseaux sociaux, il est nécessaire d'adopter un cadre de contrôle qualité très strict, en commençant par dresser une liste exhaustive des différents biais possibles [@olteanu-19].

+:::

+

+### Données de suivi de navires ou de vols

+

+Les données `AIS` sont des données de localisation de navires. AIS fait référence au système d'identification automatique utilisé par les navires partout dans le monde, utilisé à l'origine pour les échanges d'information entre navires équipés de terminaux AIS. Les données AIS sont générées et transmises de manière automatique, toutes les 2 à 10 secondes en fonction de la position et de la vitesse du navire. Lorsque ce dernier est à l'arrêt, des informations sont transmises toutes les 6 minutes. Les données transmises incluent :

+

+- Des données sur les caractéristiques des navires : identifiant, nom, type de vaisseau, taille, nationalité, etc.

+- Des données géospatiales : localisation, vitesse, etc.

+- Des données techniques supplémentaires : source de la transmission, date et heure, etc.

+

+Des applications potentielles impliquant l'utilisation des données AIS existent pour la statistique publique et pourraient être explorées par l'Insee :

+

+- Prévisions à court-terme (*nowcasting*) sur le commerce domestique et/ou international : les données AIS sont disponibles quasiment en temps réel, ce qui les rend adaptées pour faire des prévisions à court-terme. Par exemple, l'ONS (INS du Royaume-Uni) a étudie en continu l'activité maritime de 10 grands ports britanniques, en se concentrant sur deux indicateurs : le *temps passé au port* et le *trafic total*. Ces indicateurs offrent une mesure rapide du niveau de l'activité de transport maritime, qui est liée au commerce de marchandises. Ils sont à prendre en compte lors de l'élaboration d'indicateurs conjoncturels.

+- De manière similaire, le Fond Monétaire International a estimé des volumes d'échanges commerciaux à partir de données AIS et a constaté une forte corrélation avec des statistiques officielles sur le commerce, au niveau de pays individuels aussi bien qu'au niveau mondial [@cerdeiro-20].

+- Estimation des émissions de gaz à effet de serre liés au transport maritime : en appariant les données AIS avec des données relatives aux types de moteurs et à la consommation de carburant, il est possible de calculer les émissions de chaque navire. Utiliser les données AIS permet de discriminer les transports nationaux des transports internationaux [@imo-20].

+

+:::{.callout-note}

+Des défis se posent au moment d'utiliser les données AIS :

+

+- Des problèmes de qualité existent et demandent des pré-traitements spécifiques :

+ - Données corrompues à cause d'un équipement défectueux ou de conflits lors de la transmission de signaux ;

+ - La couverture des émetteurs-récepteurs terrestres est limitée aux zones proches du rivage. En haute mer, des récepteurs satellites sont utilisés pour empêcher les problèmes de transmissions mais ces derniers peuvent tout de même se produire ;

+- Les données brutes sont complexes et demandent de manière générale des pré-traitements lourds pour être utilisables. Des fournisseurs de données privées collectent, nettoient et vendent les données traitées (mais à des prix élevés). Des données pré-traitées sont aussi mises à disposition des Instituts statistiques nationaux sur la *UN Global Platform* ;

+- La taille des données constitue un fort enjeu. En effet, 310 milliards de transmissions sont effectuées chaque année. Une infrastructure adaptée est indispensable pour pouvoir traiter les données brutes ;

+:::

+

+### References

+

+::: {#refs}

+:::

diff --git a/gif/france_day_densities_cropped.gif b/gif/france_day_densities_cropped.gif

new file mode 100644

index 0000000..6adf503

Binary files /dev/null and b/gif/france_day_densities_cropped.gif differ

diff --git a/gif/france_week_densities_cropped.gif b/gif/france_week_densities_cropped.gif

new file mode 100644

index 0000000..e46d002

Binary files /dev/null and b/gif/france_week_densities_cropped.gif differ

diff --git a/gif/paris_day_densities.gif b/gif/paris_day_densities.gif

new file mode 100644

index 0000000..3cd5987

Binary files /dev/null and b/gif/paris_day_densities.gif differ

diff --git a/gif/paris_week_densities.gif b/gif/paris_week_densities.gif

new file mode 100644

index 0000000..89bb6d8

Binary files /dev/null and b/gif/paris_week_densities.gif differ

diff --git a/images.qmd b/images.qmd

new file mode 100644

index 0000000..c803a14

--- /dev/null

+++ b/images.qmd

@@ -0,0 +1,356 @@

+---

+title: "Images"

+---

+

+# Introduction

+

+Les images sont des données qui sont utilisées depuis longtemps de manière automatique.

+Une image pour un ordinateur est représentée par un tableau en 2 ou 3 dimensions (images en nuances de gris et images en couleur respectivement).

+En 2 dimensions, l'image a ainsi une longueur $L$ et une largeur $W$ :

+elle est constituée de $L \times W$ pixels, chacun associé à une valeur entière comprise entre 0 et 255

+(ou parfois à une valeur décimale comprise entre 0 et 1),

+comme illustré en @fig-image-nb.

+

+::: {#fig-image-nb}

+{ width=50% }

+

+Représentation du logo de `Python` en nuances de gris avec une faible résolution.

+La valeur de chaque pixel (entier allant de 0 pour un pixel complètement noir à 255 pour un pixel complètement blanc) figure à l'emplacement de ce dernier.

+:::

+

+Une image en couleur est constituée de 3 canaux (RGB pour *Red*, *Green* et *Blue*).

+Chacun des $L \times W$ pixels de l'image est ainsi associé à 3 valeurs entières comprises entre 0 et 225 (ou à 3 valeurs décimales comprises entre 0 et 1), comme illustré en @fig-image-couleur.

+

+::: {#fig-image-couleur layout="[[-26,14,-26], [-8,16,-1,16,-1,16,-8]]"}

+

+

+

+

+

+

+

+

+Représentation du logo de `Python` en couleurs. L'image du haut correspond

+à la superposition des trois canaux représentés sur la rangée inférieure.

+:::

+

+Le domaine de la vision par ordinateur (*computer vision*) a vu le jour dans les années 1960

+avec le développement des premiers algorithmes cherchant à extraire de l'information d'images.

+Par exemple, @sobel-73 introduit la méthode suivante pour faire de la détection de contours sur une image $A$.

+

+On calcule

+

+$$

+G_x = \begin{bmatrix}

++1 & 0 & -1\\

++2 & 0 & -2\\

++1 & 0 & -1

+\end{bmatrix} \star A \quad \text{et} \quad G_y = \begin{bmatrix}

++1 & +2 & +1\\

+0 & 0 & 0\\

+-1 & -2 & -1

+\end{bmatrix} \star A

+$$

+

+où $\star$ est l'opérateur de convolution 2-dimensionnel en traitement du signal (illustré en @fig-convol).

+

+Alors l'image $G = \sqrt{G_x^2 + G_y^2}$ fournit une représentation des contours de l'image $A$. Une illustration de l'application de cette méthode est donnée en @fig-sobel.

+

+::: {#fig-sobel layout="[-3,10,-1,10,-3]"}

+

+

+

+

+L'image de droite est obtenue par application sur l'image de gauche de la méthode de détection de contours introduite par @sobel-73. Source : [Wikipedia](https://en.wikipedia.org/wiki/Sobel_operator).

+:::

+

+::: {#fig-convol}

+{ width=60% }

+

+Illustration de l'opérateur de convolution 2-dimensionnel $\star$. Le noyau (matrice en bleu sur le dessin) est multiplié par -1 et *glisse* sur la matrice de gauche. Une multiplication élément par élément est faite sur chaque sous-matrice de la taille du noyau. Pour chacune de ces multiplication, les coefficients sont ensuite sommés pour donner une valeur de sortie unique. Par exemple ici, la valeur du pixel en vert correspond au calcul $3 = 1*(-1) + 1*1 + 1*2 + 1*1$.

+:::

+

+# La révolution du Deep Learning

+

+Dans les dernières années, l'apprentissage profond a permis une véritable révolution dans le domaine de la vision par ordinateur [@voulodimos-18].

+Les réseaux de neurone ont permis l'introduction de

+modèles complexes qui parviennent à apprendre et à représenter des données

+sur plusieurs niveaux d'abstraction,

+à l'image de la manière dont le cerveau perçoit et comprend les informations multi-modales.

+

+Ainsi, les performance *state-of-the-art* ont été largement améliorées pour une multitude de tâches différentes :

+classification d'image, segmentation sémantique, reconnaissance faciale et détection d'objets...

+Par exemple, dans le domaine de la robotique ou de la voiture autonome, ces modèles ont

+changé la donne en permettant que certaines opérations d'analyse et de décisions soient néanmoins

+applicables dans une grande diversité de scénarios.

+

+## Réseaux de neurone convolutifs

+

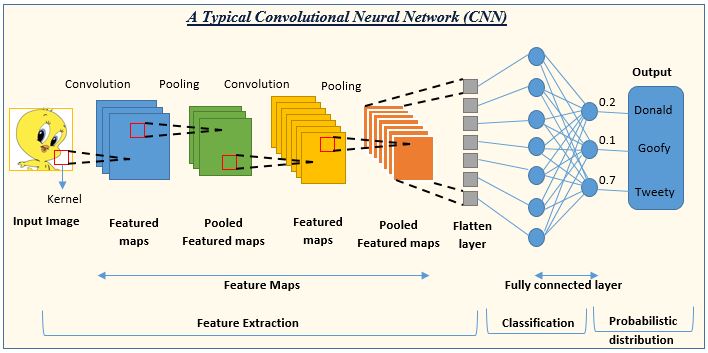

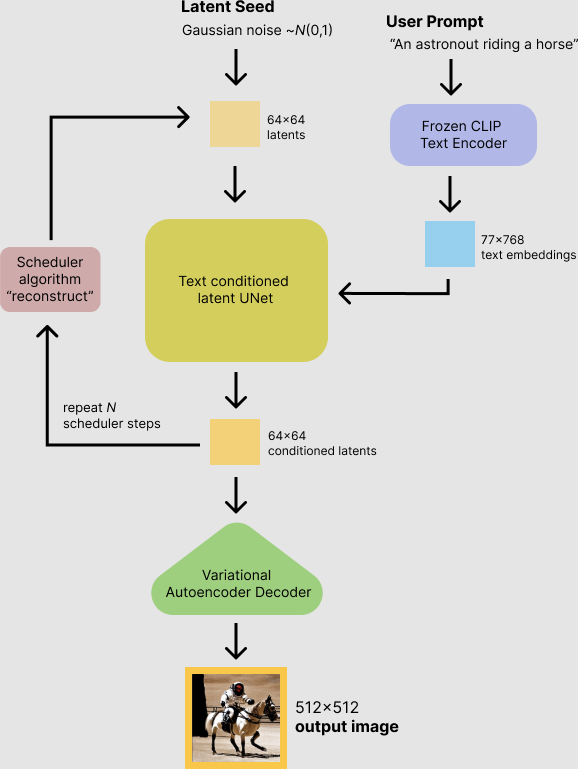

+Une architecture de modèles a joué un rôle particulièrement important dans cette révolution : les __réseaux de neurones convolutifs__ [voir @lecun-89 pour un des articles fondateurs].

+Ces réseaux de neurones sont constitués d'un enchaînement de couches convolutives, chacune composée de trois étapes :

+

+- __Une étape de *convolution*__ utilisant l'opérateur $\star$ décrit ci-dessus qui transforme un [tenseur](https://fr.wikipedia.org/wiki/Tenseur_(math%C3%A9matiques))

+3-dimensionnel de taille $(H, W, C)$ en entrée en un tenseur de taille $(H', W', C')$ ou $H'$, $W'$ et $C'$ dépendent de la taille du noyau de convolution choisi ;

+- Une __étape de *détection*__ où une fonction non-linéaire est appliquée au tenseur obtenu en sortie de l'étape de convolution ;

+- Une __étape de *pooling*__ où chaque canal du tenseur en entrée voit sa hauteur et largeur réduite à l'aide une fonction qui remplace chaque valeur par une statistique impliquant les valeurs des pixels voisins (fréquemment, la valeur maximale dans un voisinage rectangulaire : c'est l'opération de *max pooling*).

+

+La succession de ces opérations est résumée dans la @fig-nn-convol

+

+::: {#fig-nn-convol}

+

+

+

+Illustration d'une succession de séquences d'un réseau convolutionnel.

+Emprunté à https://www.analyticsvidhya.com/blog/2022/01/convolutional-neural-network-an-overview/

+

+:::

+

+Les tenseurs obtenus en sortie des couches convolutives sont appelés *activation maps* ou *feature maps*.

+Chaque *feature map* peut s'interpréter comme une carte qui indique les endroits où on peut trouver une *feature* particulière (par exemple un bord, une texture, une partie d'un objet, etc.) au sein de l'image.

+Les _features_ pertinentes (c'est-à-dire les coefficients des filtres de convolution utilisés)

+sont apprises par le réseau de neurones au cours de la phase d'entraînement.

+On peut voir ces _features_ comme des structures latentes qui combinées ensemble génèrent un objet sur

+l'image

+finale.

+

+

+Les réseaux de neurones convolutifs présentent plusieurs caractéristiques essentielles pour des tâches de vision par ordinateur, qui expliquent en partie leur succès : une invariance (relative) à la translation, la rotation et à l'échelle.

+Ces caractéristiques permettent aux modèles d'abstraire l'identité d'un objet de détails spécifiques aux images données en entrée tels que la position et l'orientation de cet objet par rapport à la caméra.

+

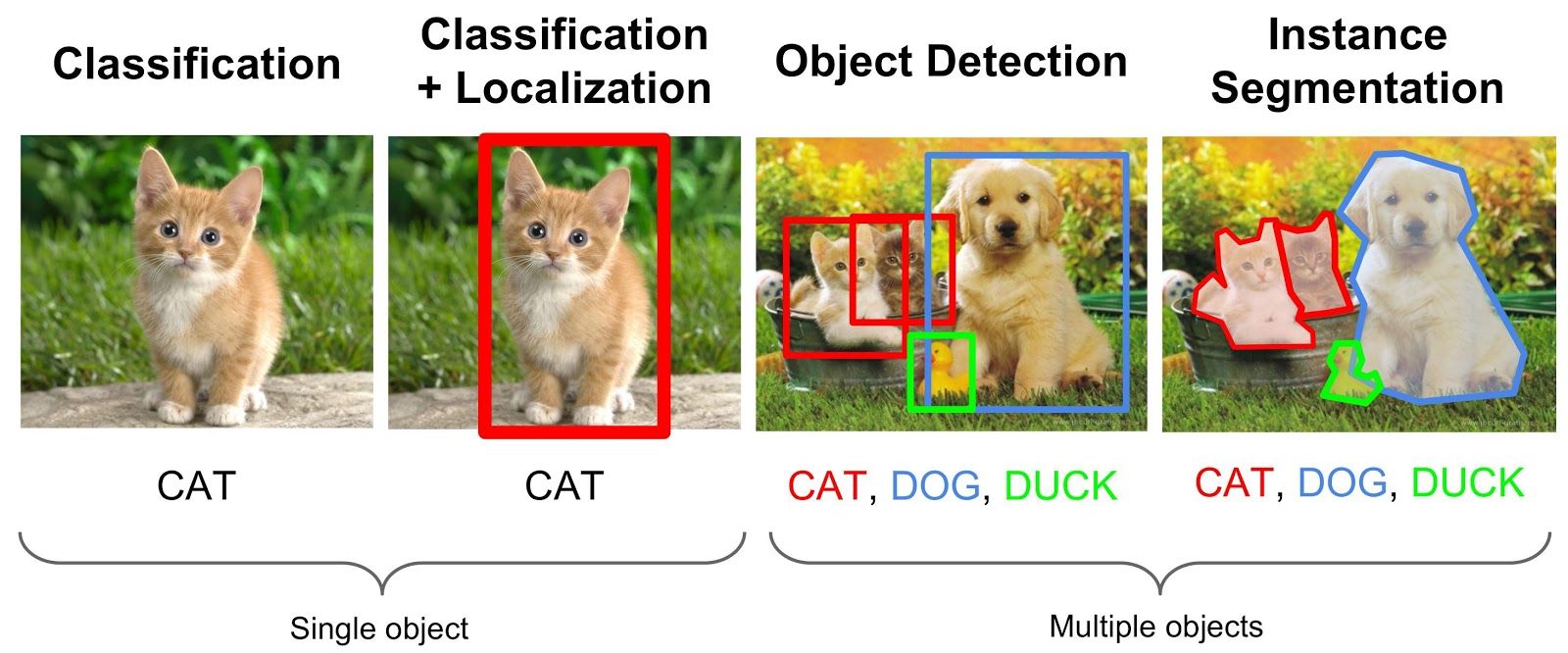

+## Segmentation sémantique

+

+La segmentation sémantique est une tâche de vision par ordinateur qui consiste à associer une étiquette ou une catégorie à chaque pixel d'une image (illustration en @fig-segmentation). Plusieurs architectures de réseaux de neurones convolutifs entraînées sur des gros jeux d'entraînement obtiennent des performances très élevées sur des jeux de données d'évaluation de référence, comme l'architecture `DeepLabV3` [@chen-17]. Les principaux frameworks de Deep Learning fournissent des implémentations de modèles de segmentation sémantique (avec ou sans coefficients pré-entraînés) : c'est le cas du package `Python` [`torchvision`](https://pytorch.org/vision/) par exemple qui propose une implémentation des modèles `DeepLabV3`, `FCN` et `LRASPP`.

+

+::: {#fig-segmentation layout-ncol=2}

+

+

+

+

+Segmentation sémantique effectuée sur une photo de chat (partie gauche de la Figure). Sur le masque de segmentation (partie droite de la Figure), les pixels verts sont associés à la classe *chat* tandis que les pixels roses sont associés à la classe *arrière-plan*. Source : [Hugging Face](https://huggingface.co/tasks/image-segmentation).

+:::

+

+::: {#fig-segmentation}

+

+

+

+

+Un autre exemple de segmentation sémantique, issu de ce [blog](https://nanonets.com/blog/semantic-image-segmentation-2020/)

+:::

+

+

+# Application à la statistique publique

+

+La statistique publique, et plus largement l'administration,

+peut désirer tirer parti des méthodes de vision par ordinateur

+de plusieurs manières.

+La suite de ce chapitre va développer quelques cas d'usages,

+non exhaustifs, des données satellites pour la statistique

+publique. Les cas d'usage sont très nombreux et ne seront

+pas tous évoqués. Par exemple, pour en savoir

+plus sur la production des données LIDAR de l'IGN,

+il est recommandé de lire [cette page](https://geoservices.ign.fr/lidarhd).

+

+

+## Utilisation de données d'observation satellitaire

+

+### Nature de la donnée

+

+Dans le domaine des données d'*Earth Observation*,

+qui regroupent en fait différentes sources de données (radars, [orthophotographies](http://geoconfluences.ens-lyon.fr/glossaire/orthophotographie)...), les données photographiques

+issues de satellites ont une place de choix.

+Celles-ci

+permettent d'observer les territoires, que ce soit leur topologie

+ou leur usage

+et potentiellement d'en tirer des enseignements à diffuser sous la forme de statistiques publiques.

+Par exemple, l'utilisation de données satellitaires peut permettre d'améliorer la granularité spatiale et temporelles de statistiques publiées aujourd'hui sur la production agricole (part du territoire cultivé, nature des cultures...).

+

+De manière générale, ces données ont beaucoup de potentiel lorsqu'elles sont utilisées en combinaison avec d'autres sources de données lorsqu'il s'agit de pallier des insuffisances ou des manques concernant les données traditionnellement utilisées pour la statistique publique. Par exemple, @steele-17 combinent données de satellites et données de téléphonie mobile pour estimer des taux de pauvreté.

+En France, les départements et régions d'outre-mer sont particulièrement concernés.

+Les données satellites permettraient d'y combler des imperfections des données administratives.